服务器系列

AI 边缘计算

NVIDIA Jetson orin 系列

采用 NVIDIA Jetson AGX Orin(64 GB)模组,算力可达 275 TOPS,支持多种 AI 大模型和深度学习框架。支持 22 路 1080P 视频解码、16 路 1080P 视频编码。配置工业级全铝合金外壳 + 两个散热风扇设计,7×24 小时稳定运行。广泛适用于边缘计算、机器人、大模型本地化、智慧城市、智慧医疗、智慧工业等行业领域

搭载 NVIDIA Jetson AGX Orin

主流 AI 大模型私有化部署

支持多种深度学习框架

AI 软件堆栈和生态系统

高带宽 LPDDR5 内存

多路视频 AI 处理性能

强大的网络通讯能力

丰富的扩展接口

搭载的 Jetson AGX Orin(64 GB)模组可提供高达 275 TOPS 算力,不仅能流畅运行机器人模型、语言大模型、视觉大模型、AI 绘画模型等主流现代 AI 模型,更可支撑更大型、更复杂的深度神经网络部署,进而实现物体识别、目标检测追踪、语音识别及其他视觉开发功能,充分满足高要求 AI 应用场景的需求

广泛适用于边缘计算、机器人、大模型本地化、智慧城市、智慧医疗、智慧工业等行业领域

EC-AGXOrin |

||

|

基本参数 |

模组 |

原装 NVIDIA Jetson AGX Orin(64GB)模组 |

|

CPU |

12核64位 ARM Cortex-A78AE v8.2 处理器,主频最高2.2GHz |

|

|

AI性能 |

275 TOPS |

|

|

GPU |

64个Tensor Core的2048核NVIDIA Ampere架构GPU |

|

|

视频编码 |

2×4K60、4×4K30、8×1080p60、16×1080p30 |

|

|

视频解码 |

1×8K30、3×4K60、7×4K30、11×1080p60、22×1080p30 |

|

|

内存(显存) |

64GB LPDDR5 |

|

|

存储 |

64GB eMMC |

|

|

扩展存储 |

1 × M.2 M-KEY(可扩展 PCIe NVMe 2280 SSD,位于主机内部)、1 × TF Card |

|

|

电源 |

DC 24V(5.5 × 2.1mm,支持9V~36V宽电压输入) |

|

|

尺寸 |

277.95mm × 136.09mm × 88.0mm |

|

|

环境 |

工作温度:-20℃~60℃,存储温度:-20℃~70℃,存储湿度:10%~90%RH(无凝露) |

|

|

软件支持 |

系统 |

基于Ubuntu 22.04的 Jetson 系统,提供了完整的桌面Linux环境,具有图形加速,支持NVIDIA CUDA、TensorRT、CuDNN 等库 |

|

大模型 |

机器人模型:支持ROS机器人模型 语言大模型:支持Transformer架构下超大规模参数模型的私有化部署,如 Deepseek-R1系列、Gemma系列、Llama系列、ChatGLM系列、 Qwen系列、Phi系列等大型语言模型的私有化部署 视觉大模型:支持 EfficientVIT、NanoOWL、NanoSAM、SAM、TAM 视觉大模型的私有化部署 AI 绘画:支持 Flux、Stable Diffusion、Stable Diffusion XL 图像生成模型的私有化部署 |

|

|

深度学习 |

支持 Ollama 本地大模型部署框架,可用于自然语言处理、代码生成与辅助等场景 支持 ComfyUI 图形化部署框架,可用于图像修复、图像风格转换、图像合成等场景 支持多种由 cuDNN 加速支持的深度学习框架,包括 PaddlePaddle、PyTorch、TensorFlow、MATLAB、MxNet、Keras 支持自定义算子开发 支持 Docker 容器化管理技术,可方便的进行镜像部署 |

|

|

AI软件堆栈 |

NVIDIA Jetson Orin 系列可提供强大的 AI 计算能力、大容量统一内存和全面的软件堆栈,能够以超高能效驱动最新的生成式 AI 应用。它能够使任何由 Transformer 架构提供支持的生成式 AI 模型进行快速推理,在 MLPerf 上实现卓越的边缘性能 |

|

|

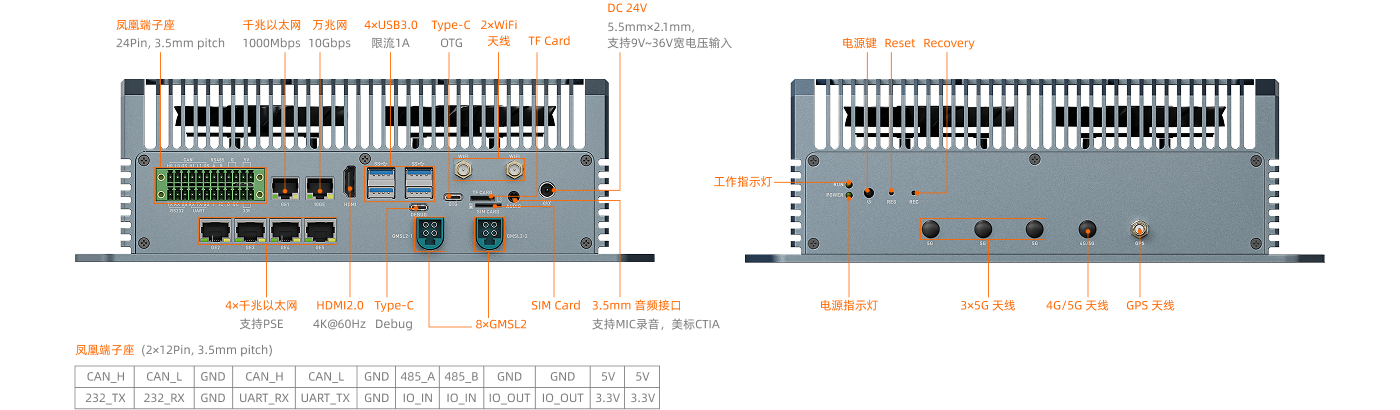

接口参数 |

网络 |

以太网:1 × 万兆网(RJ45)、5 × 千兆以太网(RJ45,其中GE2、GE3、GE4、GE5支持PSE) WiFi:通过 M.2 E-KEY(2230)扩展WiFi/蓝牙模块,支持 2.4GHz/5GHz 双频 WiFi6(802.11a/b/g/n/ac/ax)、蓝牙5.2 4G:通过 Mini PCIe 扩展 4G LTE 5G:通过 M.2 B-KEY 扩展 5G |

|

GPS |

支持GPS定位,各地的现场设备可实时定位、追踪、寻迹、时间校准(同步于全球协调时(UTC)) |

|

|

视频输入 |

8 × GMSL2(通过2个4Pin的Mini FAKRA接口输入) |

|

|

视频输出 |

1 × HDMI2.0(4K@60Hz) |

|

|

音频 |

1 × 3.5mm音频接口(支持MIC录音,美标CTIA) |

|

|

USB |

4 × USB3.0(限流1A)、1 × Type-C(USB3.2 OTG)、1 × Type-C(Debug) |

|

|

天线 |

3 × 5G天线、1 × 4G/5G天线、1 × GPS天线、2 × WiFi天线 |

|

|

按键 |

1 × Reset、1 × Recovery、1 × 电源键 |

|

|

其他接口 |

1 × SIM Card、1 × 凤凰端子座(2×12Pin,3.5mm间距):1 × RS485、1 × RS232、2 × CAN 2.0、1 × UART、1 × IO输入、1 × IO输出 |

|

欢迎反馈问题,您的意见与建议是我们的动力!

Copyright © 2014 - 2026 中山市天启智能科技有限公司 | 粤ICP备14022046号